![图片[1]-搭建本地AI聊天机器人 ollama&openwebui-RSG-人生观](https://www.lxg2016.com/wp-content/themes/zibll/img/thumbnail-lg.svg) 前言:

前言:

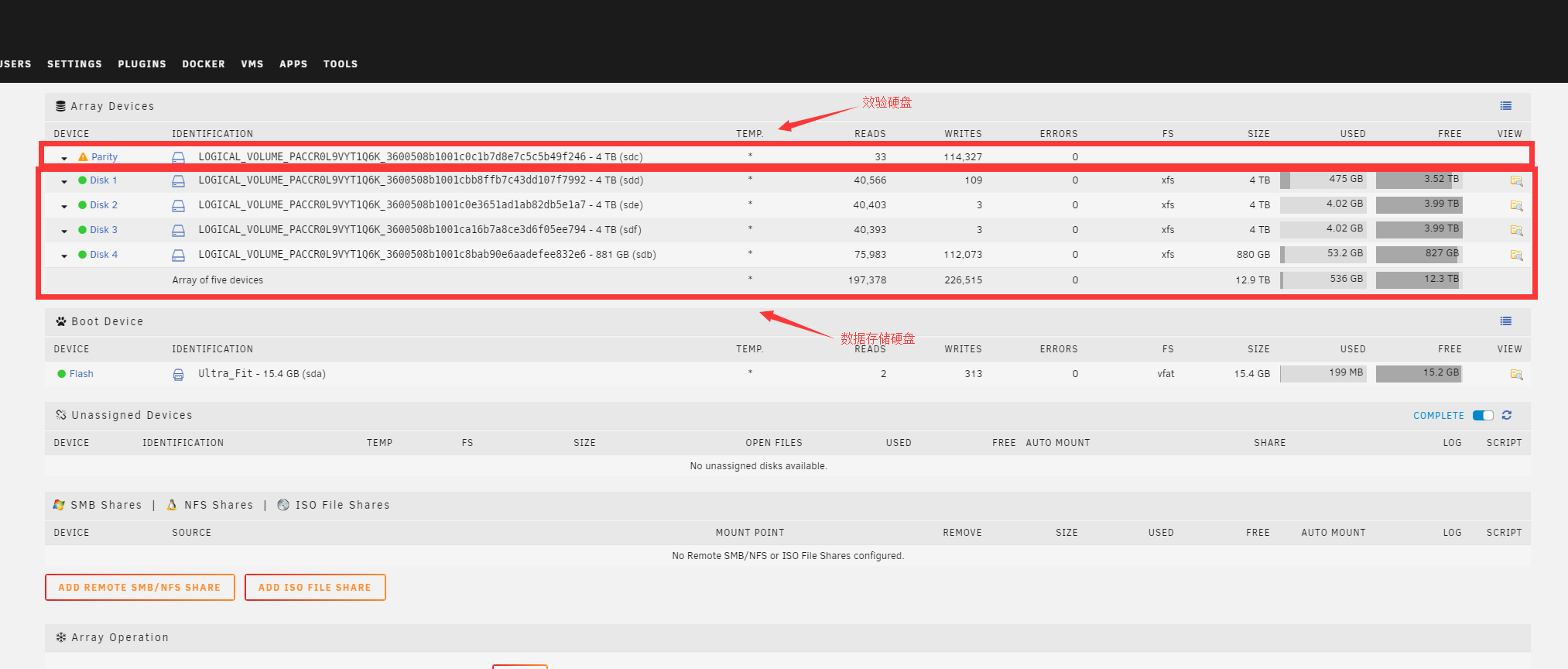

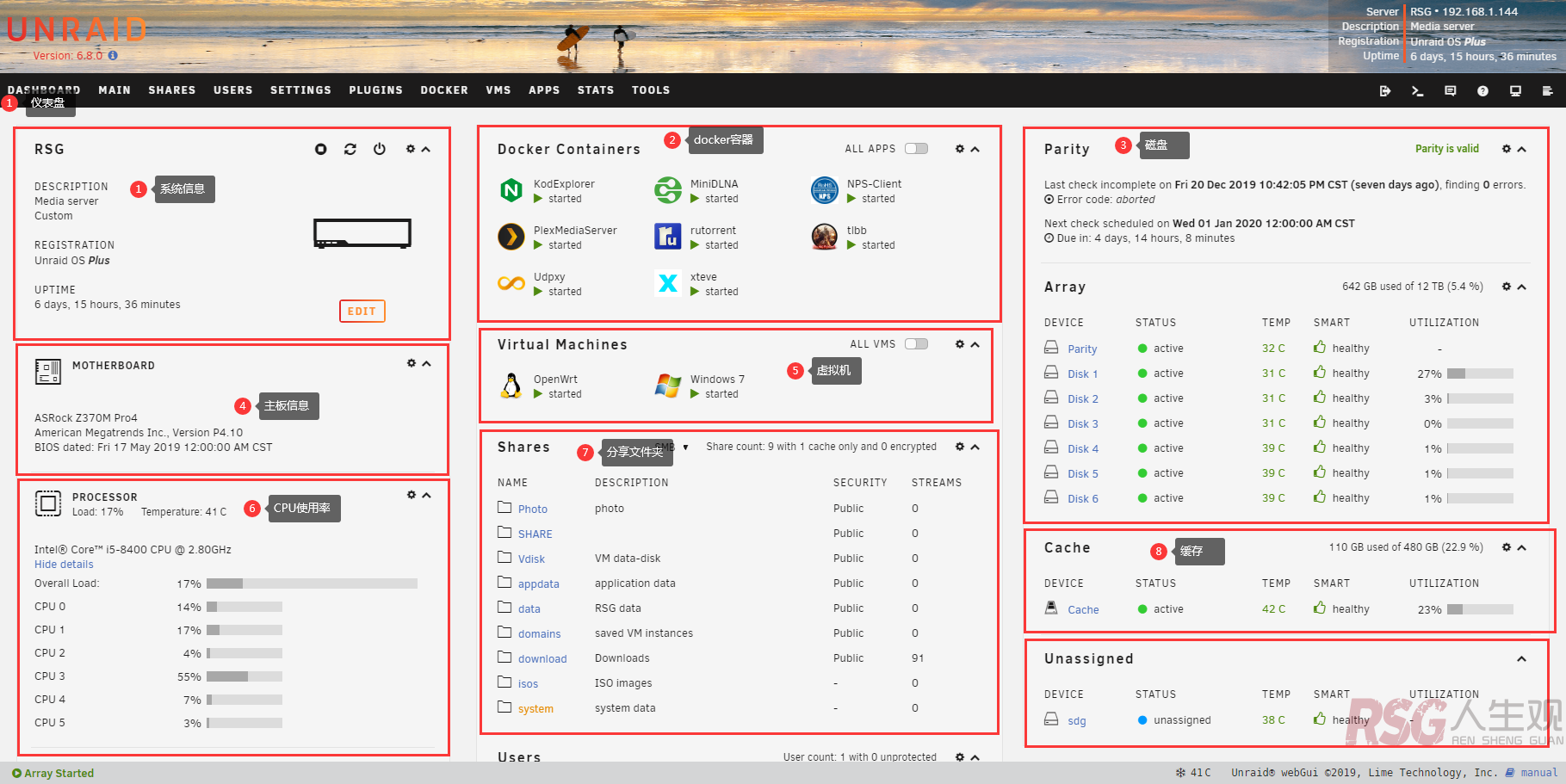

从openai的chatgpt出来后我就想本地搭建一个运行在自己服务器上的本地ai,但是在搭建前提,我也要和大家说本地搭建的模型,是不可能和网上那些比如豆包,chatgpt等等 一些ai相比的,毕竟我们个人的nas硬件性能在哪摆着呢。

在开始之前,请大家自备国际工具,部署的服务器必须可以流畅国际,听不懂你当我啥都没说。

教程:

搭建部分两部分一个是ollama,和openwebui,你可以理解为ollama是后端,openwebui是前端,提供图形界面。

搭建方式是docker compose,所以支持的系统都可以安装,硬件最好有一个nvidia的计算卡,或者显卡都可,我这里使用的是nVidia Tesla P4。

services:

#ollama

ollama:

image: ollama/ollama

container_name: ollama

runtime: nvidia

restart: always

volumes:

- "/data/appdata/ollama:/root/.ollama" ###注意替换红色标注路径为本地路径

environment:

- "NVIDIA_DRIVER_CAPABILITIES=all"

- "NVIDIA_VISIBLE_DEVICES=0"

#openwebui

openwebui:

image: open-webui/open-webui:main

container_name: openwebui

restart: always

environment:

- "OLLAMA_BASE_URL=http://ollama:11434"

volumes:

- "/data/appdata/openwebui:/app/backend/data" ###注意替换红色标注路径为本地路径

ports:

- "8080:8080" ###web访问端口,最好是修改一下8080的端口用的蛮多 大概率是会冲突。

### traefik反向代理,如果不需要,可以把整个labels全部删掉,如果需要请修改红色标注域名。

labels:

- "traefik.enable=true"

- "traefik.http.routers.openwebui2.rule=Host(`ollama.xxxx.com`)"

- "traefik.http.services.openwebui2.loadbalancer.server.port=8080"

这个是我用的compose,给大家一个参考。

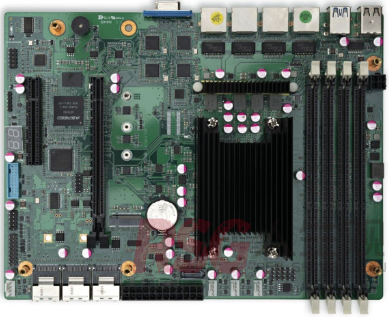

使用ip:8080端口访问openwebui

![图片[4]-搭建本地AI聊天机器人 ollama&openwebui-RSG-人生观](https://www.lxg2016.com/wp-content/uploads/2024/10/1729732498-b0070af0f63dfb4.png)

![图片[5]-搭建本地AI聊天机器人 ollama&openwebui-RSG-人生观](https://www.lxg2016.com/wp-content/uploads/2024/10/1729732724-53e953798b3d740.png)

![图片[6]-搭建本地AI聊天机器人 ollama&openwebui-RSG-人生观](https://www.lxg2016.com/wp-content/uploads/2024/10/1729733900-b4b68723fa6efcd.png)

![图片[7]-搭建本地AI聊天机器人 ollama&openwebui-RSG-人生观](https://www.lxg2016.com/wp-content/uploads/2024/10/1729733963-22eb79f268b4b28.png) 模型地址:ollama 这里以我需要的llama3.2的模型为例。

模型地址:ollama 这里以我需要的llama3.2的模型为例。

![图片[12]-搭建本地AI聊天机器人 ollama&openwebui-RSG-人生观](https://www.lxg2016.com/wp-content/uploads/2024/10/1729734704-2951401e6f61fee.png)

![图片[13]-搭建本地AI聊天机器人 ollama&openwebui-RSG-人生观](https://www.lxg2016.com/wp-content/uploads/2024/10/1729734783-c196a152b296c6e.png) 😳咳咳!还是不错的,做个简单的小翻译啥的还不错,如果你觉得每次新建窗口都要选择模型过于麻烦,你可以找一个相对于你比较满意的模型,设定为默认模型,下次在新开聊天窗口,就不需要在选择模型了。

😳咳咳!还是不错的,做个简单的小翻译啥的还不错,如果你觉得每次新建窗口都要选择模型过于麻烦,你可以找一个相对于你比较满意的模型,设定为默认模型,下次在新开聊天窗口,就不需要在选择模型了。

![图片[14]-搭建本地AI聊天机器人 ollama&openwebui-RSG-人生观](https://www.lxg2016.com/wp-content/themes/zibll/img/thumbnail-lg.svg) 结尾:

结尾:

在选择模型的时候,请大家根据自己的显卡选择,不要选择过大的,否则会炸现存,以我的计算卡P4来说选择3B或者1B 就有很好的流畅度,当然肯定没有更大的好了。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

![图片[2]-搭建本地AI聊天机器人 ollama&openwebui-RSG-人生观](https://www.lxg2016.com/wp-content/uploads/2024/10/1729732392-1bcbd94424bc9a8.png)

![图片[3]-搭建本地AI聊天机器人 ollama&openwebui-RSG-人生观](https://www.lxg2016.com/wp-content/uploads/2024/10/1729732452-905f9e3f484b9fb.png)

![图片[8]-搭建本地AI聊天机器人 ollama&openwebui-RSG-人生观](https://www.lxg2016.com/wp-content/uploads/2024/10/1729734122-1017833cb1f4208.png)

![图片[9]-搭建本地AI聊天机器人 ollama&openwebui-RSG-人生观](https://www.lxg2016.com/wp-content/uploads/2024/10/1729734182-7188eb40d1f95b3.png)

![图片[10]-搭建本地AI聊天机器人 ollama&openwebui-RSG-人生观](https://www.lxg2016.com/wp-content/uploads/2024/10/1729734252-8f5d3473ab5492a.png)

![图片[11]-搭建本地AI聊天机器人 ollama&openwebui-RSG-人生观](https://www.lxg2016.com/wp-content/uploads/2024/10/1729734302-35a98850996065c.png)

![图片[14]-搭建本地AI聊天机器人 ollama&openwebui-RSG-人生观](https://www.lxg2016.com/wp-content/uploads/2024/10/1729734897-6818040b1964571.png)

- 最新

- 最热

只看作者