![图片[1]-immich 配置支持中文的CLIP 模型 让immich可以中文搜索-RSG-人生观](https://www.lxg2016.com/wp-content/themes/zibll/img/thumbnail-lg.svg) 前言:

前言:

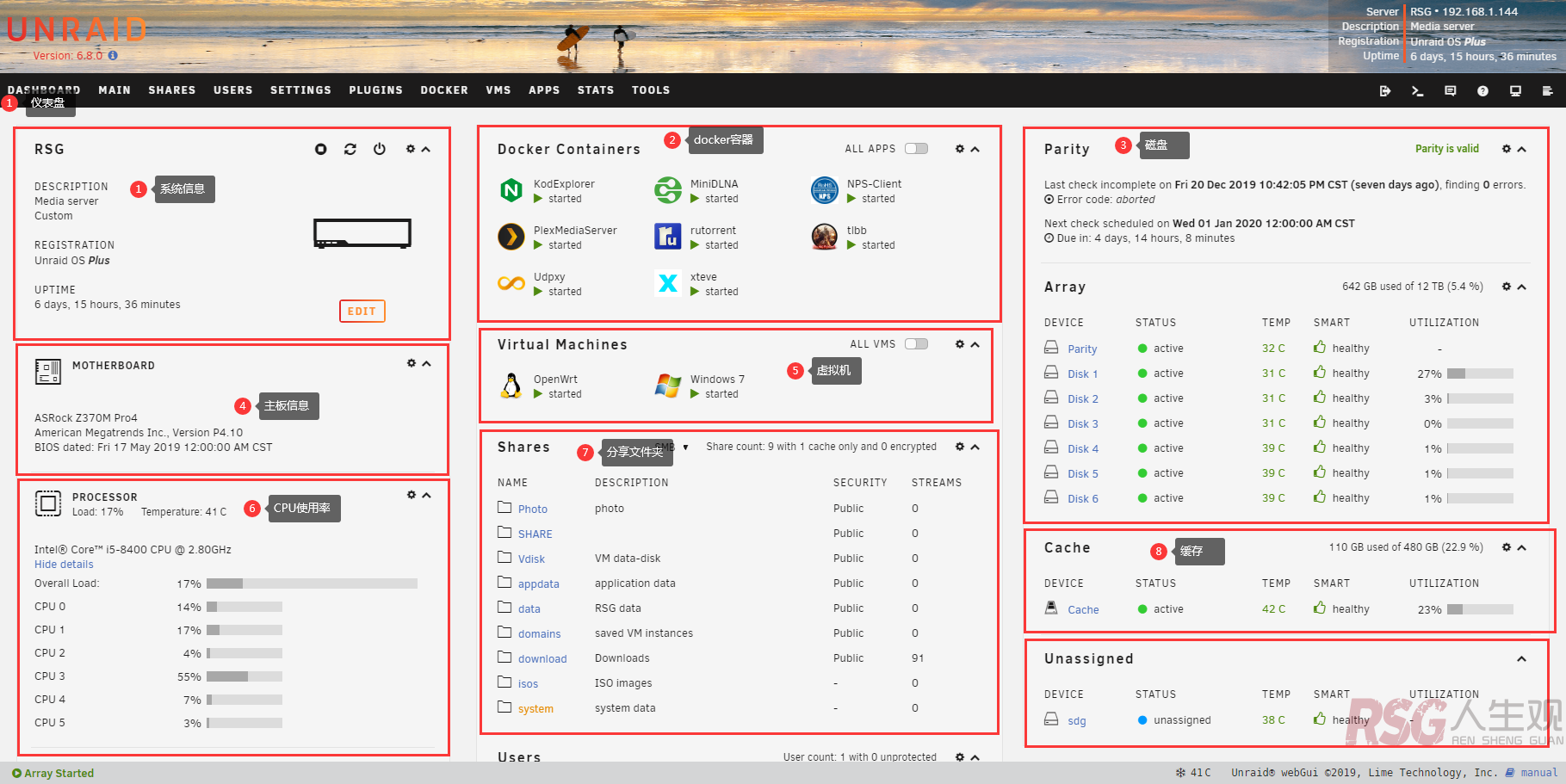

之前的教程,搭建了immich还有让immich支持中文题图,但是导入照片后,想搜索内容的时候发现默认ai并不能支持中文检索,模型对中文支持非常不友好,今天来搞一个支持中文的模型,方便我们搜索。

教程:

注意,在开始之前,我们的服务端要能国际网络,不懂是啥请自行百度,写了模型之后服务端会自动联网下载,后端链接的服务器并不能良好下载,所以需要国际网络,如果没有我也提供本地方法。

模型名字:immich-app/XLM-Roberta-Large-Vit-B-16Plus

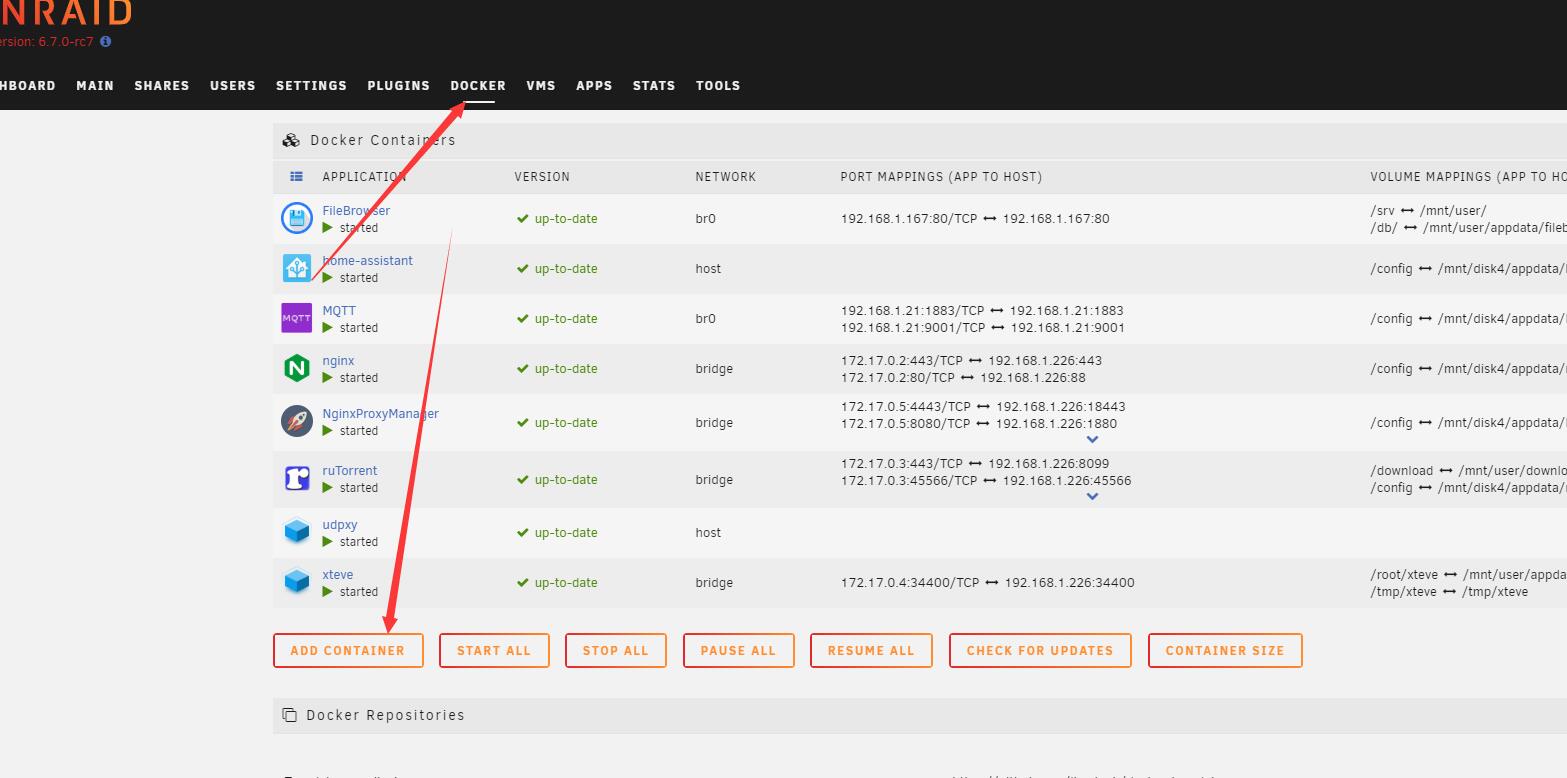

离线方式有点麻烦,我们先下载XLM-Roberta-Large-Vit-B-16Plus模型,复制到immich-machine-learning容器映射的cache路径。

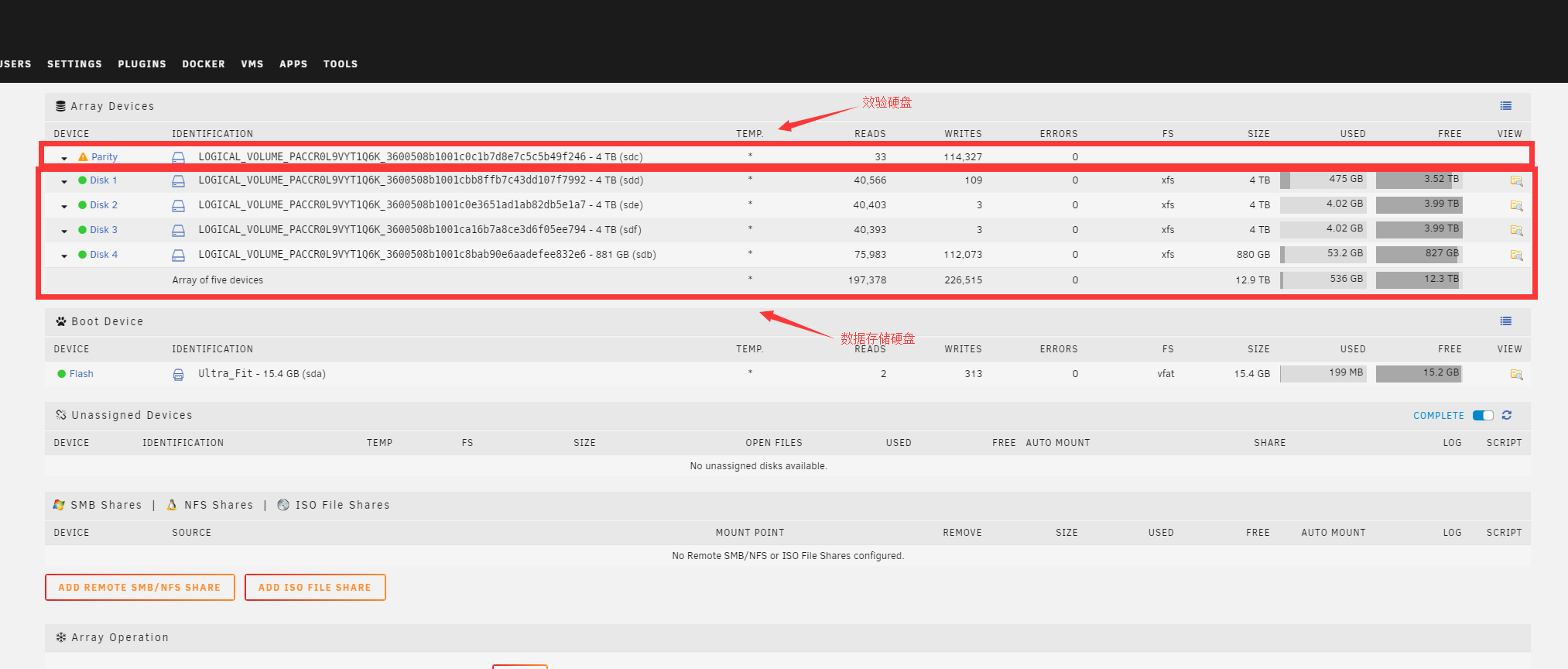

比如我这个图片的配置,容器内部的/cache 对应的宿主机路径是/data/appdata/immich/cache,所以我们下载的模型就要放在/data/appdata/immich/cache/clip,如果没有clip可以自己创建一个,然后把下载到的模型放到里面,然后重启immich-machine-learning容器

重启命令:

docker restart immich-machine-learning

注意,这是使用我的教程搭建的可以使用,如果是其他,请自行查看你容器的名字 可以用 docker ps -a

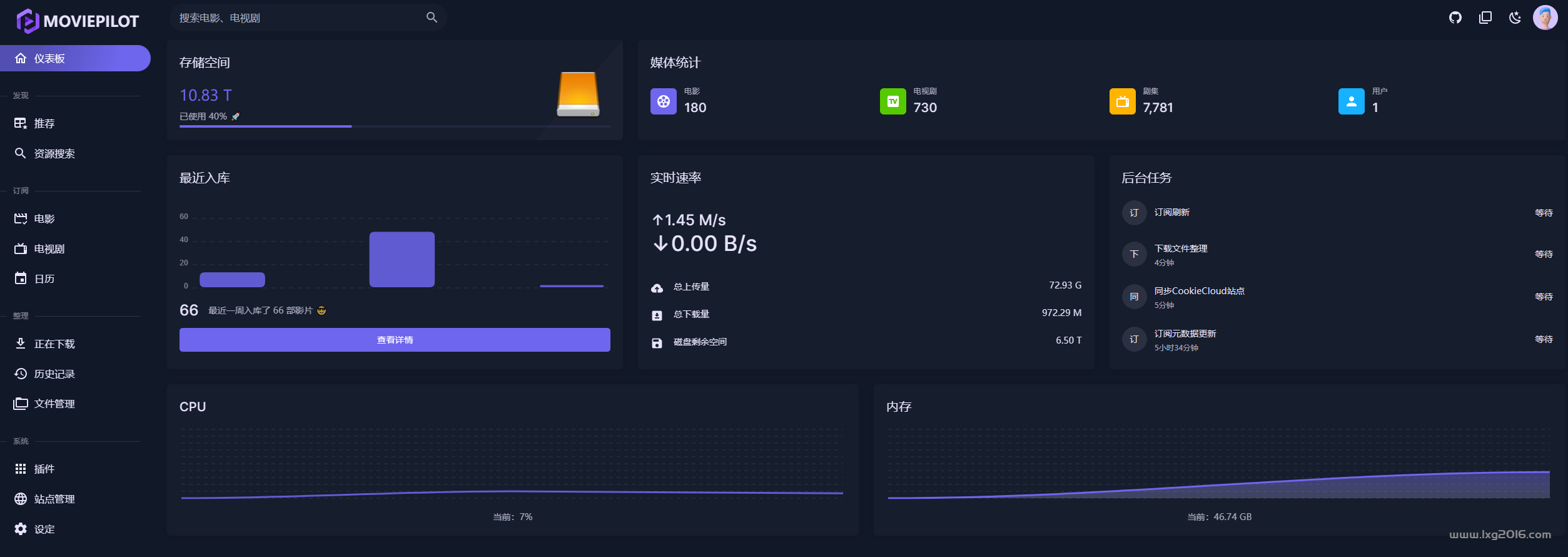

在进入 immich的管理-设置-机器学习修改clip的内容。

刷新的时候,可以去看一下immich-machine-learning容器的日志。

![图片[9]-immich 配置支持中文的CLIP 模型 让immich可以中文搜索-RSG-人生观](https://www.lxg2016.com/wp-content/uploads/2024/10/1729222026-e37a20173fa4aab.png) 这样就基本没啥问题了,智能搜索刷新后,就可以测试搜索了,这里我就不在放图了。

这样就基本没啥问题了,智能搜索刷新后,就可以测试搜索了,这里我就不在放图了。

结尾:

到此,更换支持中文的clip模型的教程就结束了,至于离线模型,我会上传到百度网盘或者阿里网盘,等上传结束后,我在增加下载。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

![图片[1]-immich 配置支持中文的CLIP 模型 让immich可以中文搜索-RSG-人生观](https://www.lxg2016.com/wp-content/uploads/2024/10/1728976379-f956cf9faec489e.png)

![图片[2]-immich 配置支持中文的CLIP 模型 让immich可以中文搜索-RSG-人生观](https://www.lxg2016.com/wp-content/uploads/2024/10/1729221047-199536a9c0f9108.png)

![图片[3]-immich 配置支持中文的CLIP 模型 让immich可以中文搜索-RSG-人生观](https://www.lxg2016.com/wp-content/uploads/2024/10/1729221144-2dbe641b574d730.png)

![图片[4]-immich 配置支持中文的CLIP 模型 让immich可以中文搜索-RSG-人生观](https://www.lxg2016.com/wp-content/uploads/2024/10/1729221218-78d71b390dce33c.png)

![图片[5]-immich 配置支持中文的CLIP 模型 让immich可以中文搜索-RSG-人生观](https://www.lxg2016.com/wp-content/uploads/2024/10/1729221582-d7cf83dfbd9bef2.png)

![图片[6]-immich 配置支持中文的CLIP 模型 让immich可以中文搜索-RSG-人生观](https://www.lxg2016.com/wp-content/uploads/2024/10/1729221508-2aafee050a0c9b3.png)

![图片[7]-immich 配置支持中文的CLIP 模型 让immich可以中文搜索-RSG-人生观](https://www.lxg2016.com/wp-content/uploads/2024/10/1729221920-83bc2e2be022fd3.png)

暂无评论内容